Microsoft annuncia Phi-3, la famiglia di modelli linguistici di piccole dimensioni

I Large Language Models stanno diventando sempre più grandi: alcuni di questi hanno centinaia di miliardi o addirittura trilioni di parametri. A questo proposito, diversi mesi fa, i ricercatori di Microsoft si sono chiesti: “Quanti parametri sono davvero necessari per costruire un modello che offra un ragionamento di senso comune?”. La risposta è arrivata con la nuova famiglia di modelli linguistici di piccole dimensioni Phi-3 e il primo Phi-3-mini (con soli 3,8 miliardi di parametri), ora disponibile attraverso Azure, HuggingFace e Ollama.

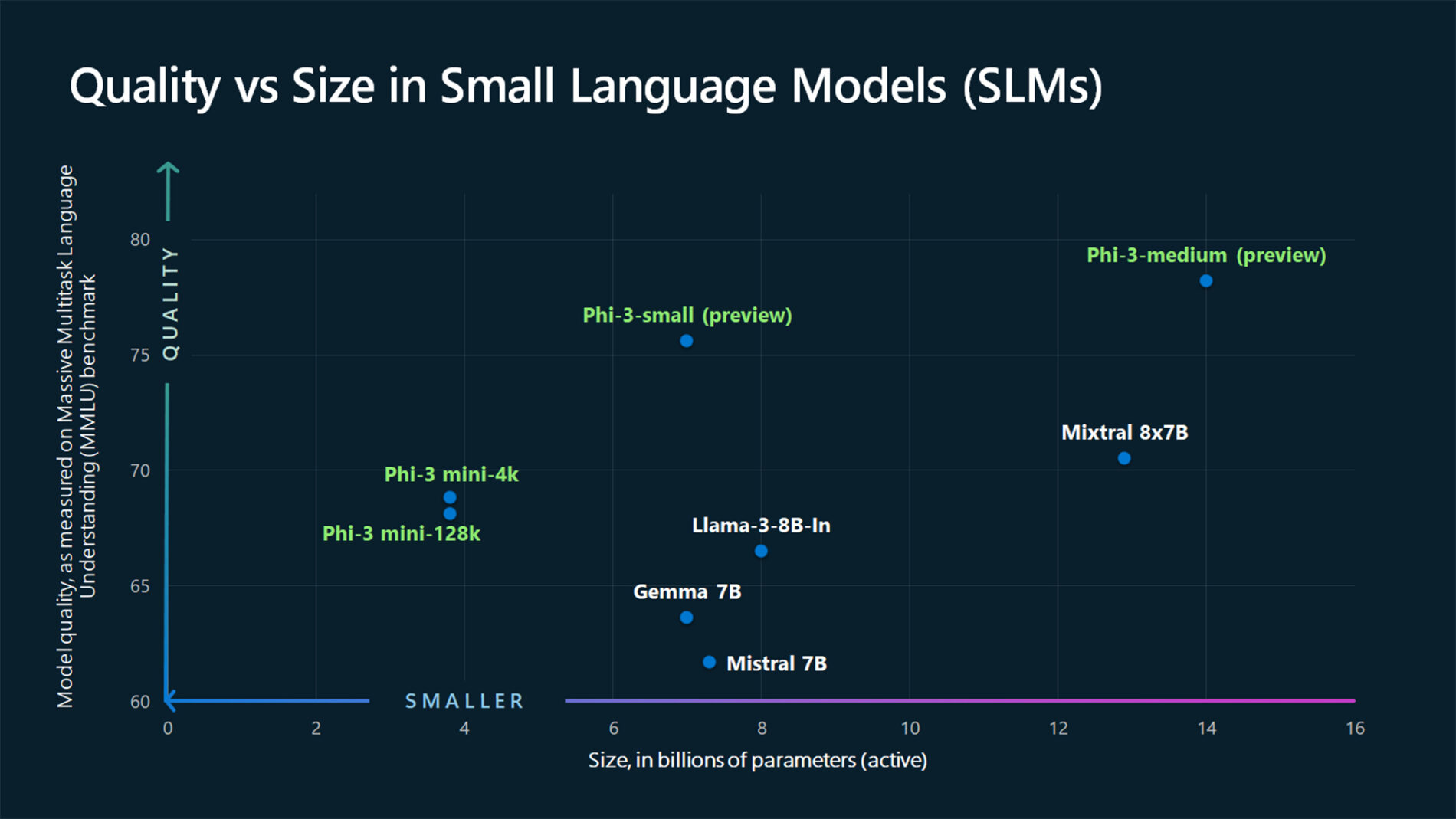

Addestrato su dati sintetici di alta qualità, Phi-3 ha uno dei migliori rapporti costo-prestazioni di qualsiasi altro modello sul mercato ed è in grado di superare modelli di dimensioni fino a 10 volte superiori, dimostrando che un numero maggiore di parametri non è necessariamente la scelta migliore e offrendo una nuova opzione per i clienti con esigenze diverse in termini di costi, latenza e infrastruttura.

Di seguito alcuni dettagli sulla nuova soluzione:

Phi-3 dimostra che i dati sintetici di alta qualità sono un’opzione valida per l’addestramento dei modelli linguistici e crea opportunità uniche per ulteriori innovazioni.

- Questa innovazione è nata nei laboratori di ricerca di Microsoft ed è stata ampliata dal nuovo team GenAI dell’azienda. Il team ha sviluppato tecniche ispirate al modo in cui i bambini imparano utilizzando le storie della buonanotte e ha migliorato il set di dati approcciando la loro selezione come un insegnante che spiega concetti difficili a uno studente.

- Oltre a tutte le altre fasi legate alla Responsible AI che vengono adottate prima di rilasciare un modello, l’addestramento che sfrutta i dati sintetici ha permesso a Microsoft di aggiungere un ulteriore livello di sicurezza e di ridurre i problemi più comuni legati all’uso di un linguaggio dannoso come quello che spesso viene mostrato dai modelli addestrati su dati provenienti da Internet.

La famiglia di modelli Phi-3 può contribuire ad abbattere le barriere associate a costi ed efficienza.

- Phi-3-mini ha 3,8B parametri, ma supera i competitor più grandi. Ciò significa che i compiti che normalmente verrebbero affidati a un modello più grande possono essere gestiti da una soluzione che offre un ingombro minore.

- Grazie alla sua dimensione ridotta Phi-3 è facile da implementare e meno costoso e può essere utilizzato per casi d’uso personalizzati.

- Phi-3-small (parametri 7B) e Phi-3-medium (parametri 14B) saranno presto disponibili e offriranno proposte di valore simili con prestazioni scalari.

Microsoft sostiene la community degli sviluppatori rendendo Phi-3 disponibile su più piattaforme.

- Phi-3 sarà disponibile su HuggingFace e Ollama oltre che su Azure, consentendo a chiunque di eseguire il modello localmente e di sfruttare i vantaggi dell’AI generativa.

- Le dimensioni ridotte di Phi-3-mini consentiranno agli utenti di eseguire il modello sul dispositivo senza la necessità di una connessione a Internet o di un accesso al cloud, ampliando l’accesso all’intelligenza artificiale in luoghi privi delle infrastrutture necessarie per sfruttare gli LLM.

Ulteriori informazioni sono disponibili su Microsoft Source e sul Azure Blog.

Commenta la notizia

Vuoi un'immagine profilo personalizzata? Impostala su Gravatar utilizzando la stessa e-mail associata ai commenti.